Gustavo

Doppelspitze 2019

- Mitglied seit

- 22.03.2004

- Beiträge

- 7.228

- Reaktionen

- 2.797

Faszinierend. Der Prompt geht bei mir auch. Noch lustiger:

Wenn ich zuerst deinen Prompt verwende und direkt danach noch mal den der bei mir gestern nicht ging, geht der auch. Aber nicht wenn ich nur den in einer neuen Session mache.

Also ChatGPT hat definitiv exakt die Information, jeder Versuch sich mit "ist nicht in den Trainingsdaten" rauszureden ist falsch. Und man könnte daraus jetzt viel spekulieren wie genau die Filter funktionieren - muss jedenfalls irgendwie die ganze Session berücksichtigen.

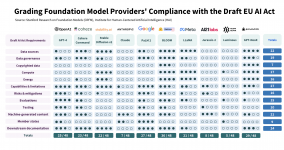

Das war nur eine Illustration. Das ist zufällig etwas, womit ich mich auskenne und ich wollte mal sehen was er aus dem Prompt macht, weil der UCR keine offizielle "homicide rate" mehr ausweist, nur eine Mordzahlen unter einer Großrubrik "homicide"*. Konsequenterweise sind die Zahlen auch erfunden, soweit ich das sehen kann. Sie sind nicht komplett unplausibel, aber auch nicht super nah an der Wahrheit. Punkt ist: Ich wäre vorsichtiger mit solchen Fragen.

*der Hauptgrund ist einerseits, dass die Datengrundlage für den UCR von jeder Polizeibehörde einzeln geliefert wird und den staatlichen Gesetzen folgt, die häufig variieren (d.h. manche Staaten haben neuen Mord auch Homicide, andere haben nur involuntary oder vehicular homicide und wieder andere haben keine davon, d.h. jede absichtliche Tötung wird als Mord gewertet) und andererseits weil Homicide als eigener Straftatbestand seit Anfang der 1980er aus irgendeine Grund kaum noch verwendet wird, davor aber durchaus häufig